网站首页 互联网 > 正文

在计算神经网络时,传统的计算机芯片已经达到了极限。英伟达、谷歌等公司开发的图形处理器和AI专用硬件更强大。神经形态学芯片与真实神经元基本相似,工作效率高。量子计算机也可以大大提高计算能力。

没有人工智能,就不可能实现自动驾驶和自动驾驶功能。所需的计算能力由专门从事并行计算的特殊芯片提供。但研究人员也在研究新的、受生物学启发的解决方案,以及有望实现更高计算能力的量子计算机。

几十年来,电子技术在汽车上变得越来越流行。如今,数十种网络控制设备控制发动机、变速器、信息娱乐系统和许多其他功能。汽车已经成为滚动计算中心,但现在,计算机功能的新飞跃正在等待着它们,因为自动驾驶功能和自动驾驶需要越来越强大的计算机。而且由于传统芯片无法达到要求的性能,是时候让图形处理器、张量处理单元(TPU)等硬件专门为计算神经网络而设计了。

虽然传统的中央处理器可以广泛使用,但它们缺乏最佳的人工智能架构。这是由于神经网络训练和推理过程中的典型计算。“神经网络中的矩阵乘法非常复杂,”卡尔斯鲁厄理工学院(KIT)Steinbuch计算中心的markusgtz博士解释道。“但这些计算非常适合并行化,尤其是对于显卡。一个拥有24个内核和矢量命令的高端CPU,每个周期可以执行24次4次计算。配备现代显卡的显卡超过5000张。”

图形处理器(GPU,图形处理单元)从一开始就是为并行运算而设计的,其内部架构也是为此量身定制的:GPU包含数百个简单的整数和浮点运算计算模块,可以同时对相同功能的不同数据进行运算(单指令多数据)。因此,它们可以在每个时钟周期执行数千次计算操作——例如,计算虚拟景观的像素或神经网络的矩阵乘法。因此,毫无疑问,GPU制造商NVIDIA目前处于理想的位置,成为人工智能总体上,尤其是自动驾驶领域的主力军。大众汽车使用美国公司的硬件。保时捷工程软件开发高级经理拉尔夫鲍尔说:“自动驾驶需要特殊的硬件。”“GPU是起点;稍后,可能会推出专用芯片。”

NVIDIA目前提供专门针对自动驾驶的Xavier流程。一个硅芯片配备了八个传统的中央处理器和一个为机器学习优化的图形处理器。对于2级以上的自动驾驶(与2级相比,基于标准传感器的有限垂直和水平控制以及增强功能),可以使用Drive AGX Xavier平台,该平台每秒可执行多达30万亿次计算操作(每秒30次TOPS、Tera操作)。为了实现高度自动化和自动驾驶,英伟达拥有Drive AGX Pegasus (320 TOPS)。在没有人为干预的情况下,测试车可以行驶80公里而不经过硅谷。作为Xavier的继任者,NVIDIA目前正在开发Orin GPU,尽管对其性能数据知之甚少。

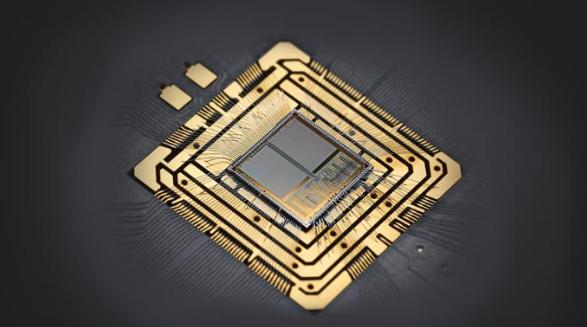

并非所有汽车制造商都使用GPU。2016年,特斯拉开始研发自己的神经网络处理器。自2019年初以来,这家美国公司在其车辆上安装了FSD芯片,而不是英伟达的图形处理器。除了两个神经处理单元(npu)(每个单元72个TOPS)之外,它还包含用于常规计算的12个常规CPU内核和用于图像和视频数据后处理的GPU。像GPU这样的npu是并行且专用的,因此可以快速执行加法和乘法运算。

用于AI应用的谷歌芯片。

谷歌是芯片业务的另一个新兴市场:自2015年以来,这家科技公司一直在其数据中心使用自开发的TPU。这个名字来自数学术语“张量”,它包括向量和矩阵等元素。这就是为什么谷歌广泛使用的人工智能软件库叫做TensorFlow,这个芯片是经过优化的。谷歌在2018年推出第三代TPU,包含4个“矩阵乘法单元”,据说可以实现90个TFLOPS(每秒浮点运算)。谷歌的子公司Waymo利用TPU来训练自动驾驶的神经网络。

0%;" />诸如Tesla的FSD或Google的TPU之类的专用芯片只有大量使用时才变得经济。一种替代方法是FPGA(现场可编程门阵列)。这些通用的数字芯片包含无数的计算和存储块,可以通过编程将它们相互组合在一起,并可以将算法实质上注入到硬件中(例如使用专用芯片,但价格便宜得多)。FPGA可以轻松地适应AI应用程序的特定要求(例如指定的数据类型),从而在性能和能耗方面产生好处。总部位于慕尼黑的初创公司Kortiq已开发出用于FPGA的AIScale架构,

一些研究人员正在寻求与AI专用芯片的神经细胞功能更加紧密的联系。海德堡大学的研究人员开发了神经形态系统BrainScaleS,其人工神经元被实现为硅芯片上的模拟开关:细胞体由大约1,000个晶体管和两个电容器组成,突触大约需要150个晶体管。可以将单个细胞体作为模块组合以形成各种类型的人工神经元。这些突触可以像自然界中那样形成牢固的连接,并且还具有兴奋性和抑制性类型。神经元的输出由“尖峰”组成,持续数微秒的短电压脉冲充当其他人工神经元的输入。

能神经芯片

但是BrainScaleS不仅用于研究人脑。技术神经元还可以用于解决技术问题,例如自动驾驶的目标检测。一方面,它们提供了约200万个神经元的每个模块约1万亿次运算操作(1,000 TOPS)的高计算能力。另一方面,模拟解决方案也消耗很少的能量。“例如,在数字电路中,每次操作使用大约10,000个晶体管,”海德堡大学的Johannes Schemmel解释说。“我们的耗电量大大减少,这使我们能够达到每瓦约100 TOPS。” 研究人员刚刚开发了第二代电路,并正在与行业合作伙伴讨论可能的合作。

来自云的量子能量

将来,甚至量子计算机也可以用于AI领域。它们的基本单位不是二进制位,而是具有无限数量可能值的qubit。借助量子力学定律,可以使计算高度并行化,从而加速计算。同时,由于量子位由诸如电子,光子和离子之类的敏感物理系统表示,因此量子计算机很难实现。例如,IBM Q System One演示了这一点,该公司在拉斯维加斯举行的CES 2019电子贸易展上推出了IBM Q System One。量子计算机的内部必须严格屏蔽振动,电场和温度波动。

神经细胞和人工神经元

神经细胞 通过突触接收其他神经元发出的信号,这些突触位于树突上或直接位于细胞体上。突触可具有兴奋作用或抑制作用。所有输入都在轴突岗进行汇总,如果在此过程中超过阈值,则神经细胞会发出一个大约毫秒级的信号,该信号沿着轴突传播并到达其他神经元。

人工神经元 或多或少准确地模仿了这种行为。在具有多层的传统神经网络中,每个“神经细胞”都接收加权和作为输入。它由前一层神经元的输出和加权因子w i组成,其中存储了神经网络的学习经验。这些加权因子对应于突触,也可以是兴奋性的或抑制性的。像神经细胞一样,可配置的阈值确定何时人工神经元触发。

从神经网络学习和推理

自然和人工神经网络从突触连接强度和加权因子的变化中学习。在深度神经网络中,在训练过程中,将数据馈送到输入和输出,并与所需结果进行比较。使用数学方法, 不断调整加权系数w ij,直到神经网络可以可靠地放置图像(例如指定类别)。通过推论,例如,数据被馈送到输入,而输出则被用于决策。

在深度神经网络(具有多层人工神经元的网络)的训练和推理中,相同的数学运算会重复发生。如果将第1层神经元的输出和第2层神经元的输入都作为列向量相加,则所有计算都可以表示为矩阵乘法。在此过程中,发生了许多相互独立的乘法和加法,这些运算可以并行执行。常规CPU并非为此目的而设计的-这就是图形处理器,TPU和其他AI加速器在很大程度上优于它们的原因。

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,多谢。免责声明: 本文由用户上传,如有侵权请联系删除!

- 上一篇: 利用AI区分网络 判断给定网络是否具有量子优势

- 下一篇: 推特称AI推特推荐帮助其增加了数百万用户

猜你喜欢:

- 2023-07-05 被遗忘的国度 恶魔之石心得(遗忘国度:恶魔之石)

- 2023-07-05 怎样做到勤能补拙(勤能补拙的方法)

- 2023-07-05 手机上在哪里查询生育险(手机上在哪里查询生育险余额)

- 2023-07-05 跑步膝盖疼的原因及解决方法(跑步膝盖疼的原因及解决方法图片)

- 2023-07-05 山羊画什么脚印(山羊画什么脚印像什么)

- 2023-07-05 设计图:君王板甲护腕如何获得?(君王板甲腰带图纸获取办法)

- 2023-07-05 电脑如何恢复出厂设置win7(笔记本电脑如何恢复出厂设置win7)

- 2023-07-05 DOTA中的骷髅王出装推荐(dota2骷髅王最强出装)

最新文章:

- 2023-07-05 上海搬家公司价格查询怎样进行普通搬家多少钱?(上海搬家公司价格表一览)

- 2023-07-05 电脑网页打开很慢怎么办(电脑网页打开很慢怎么办有时还打不开)

- 2023-07-05 拳皇WingEx1.0隐藏技能怎么用(拳皇wingex1.02隐藏技能)

- 2023-07-05 《名将传说》新手攻略5大职业特色技能详解(《名将传说》新手攻略5大职业特色技能详解介绍)

- 2023-07-05 如何锻炼口才(如何锻炼口才和思维能力)

- 2023-07-05 sumifs函数的使用方法(sumifs函数的使用方法日期)

- 2023-07-05 win10回收站图标不能正常显示怎么办(windows10只有回收站图标)

- 2023-07-05 长沙周边一日游 农家乐农的传人值得你去一趟(长沙农家乐好去处)

- 2023-07-05 联想a789刷机教程 最简单的线刷方法等你分享

- 2023-07-05 育苗块怎么用(育苗块怎么使用)

- 2023-07-05 瑜伽冥想有哪些好处(瑜伽冥想有哪些好处呢)

- 2023-07-05 海鱼的做法大全(海鱼的做法大全视频)

- 2023-07-05 招商银行缴纳学费(招商银行缴纳学费步骤)

- 2023-07-05 qq空间怎么添加音乐(QQ空间如何添加音乐)

- 2023-07-05 如何在淘宝上开店(淘宝店铺怎么开)

- 2023-07-05 女孩子喜欢什么礼物(给女孩子送什么礼物比较好)